Lorsque la Nvidia GeForce RTX 4090 a été annoncée avec un prix alléchant de 1 600 $, les mèmes se sont répandus comme une traînée de poudre. Alors que 1 600 $, c’est un peu trop pour la plupart des joueurs à dépenser pour un seul composant (la plupart des budgets de construction de PC que je vois sont inférieurs à ceux de l’ensemble du PC). Je ne pouvais pas m’empêcher d’être intrigué par les améliorations potentielles des performances de mon travail – vous savez, les tâches accélérées par la 3D et l’IA que je passe la majeure partie de ma journée à faire dans le cadre de la gestion de la chaîne YouTube EposVox, au lieu de jouer.

Spoiler alert : les performances de création de contenu de la GeForce RTX 4090 sont magiques. Dans de nombreux cas, l' »augmentation des performances 2X » généralement absurde est en fait vraie. Mais pas partout.

GeForce RTX 4090 Founders Edition

Notre configuration de test

La plupart de mes benchmarks ont été effectués sur ce banc de test :

- Intel Core i9-12900k CPU

- 32GB Corsair Vengeance DDR5 5200MT/s RAM

- ASUS ROG STRIX Z690-E Gaming Wifi Motherboard

- EVGA G3 850W PSU

- Source files stored on a PCIe gen 4 NVMe SSD

Mes objectifs étaient de voir à quel point la RTX 4090 serait mise à niveau par rapport à la génération précédente GeForce RTX 3090, ainsi que la RTX Titan (la carte sur laquelle je travaillais principalement auparavant). Le RTX 3090 a vraiment vu des améliorations minimes par rapport au RTX Titan pour mes cas d’utilisation, donc je n’étais pas sûr que le 4090 serait vraiment un grand pas en avant. Pour des tests plus approfondis plus tard, comme je le mentionnerai, des tests ont été effectués sur ce banc d’essai.

- AMD Threadripper Pro 3975WX CPU

- 256GB Kingston ECC DDR4 RAM

- ASUS WRX80 SAGE Motherboard

- BeQuiet 1400W PSU

- Source files stored on a PCIe gen 4 NVMe SSD

Chaque test présentait chaque GPU dans la même configuration afin de ne pas mélanger les résultats.

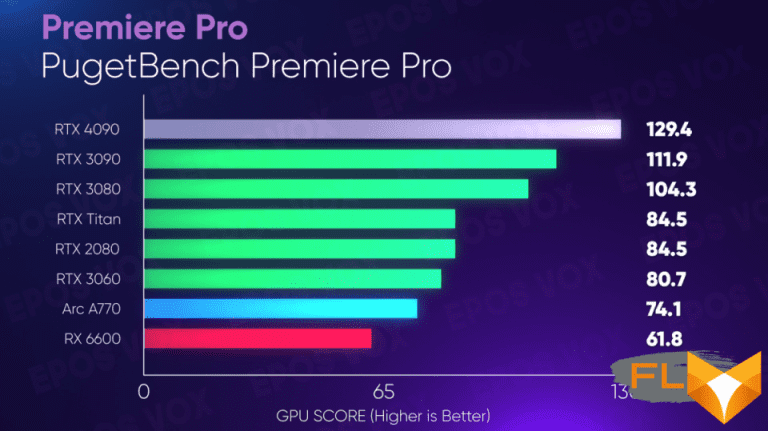

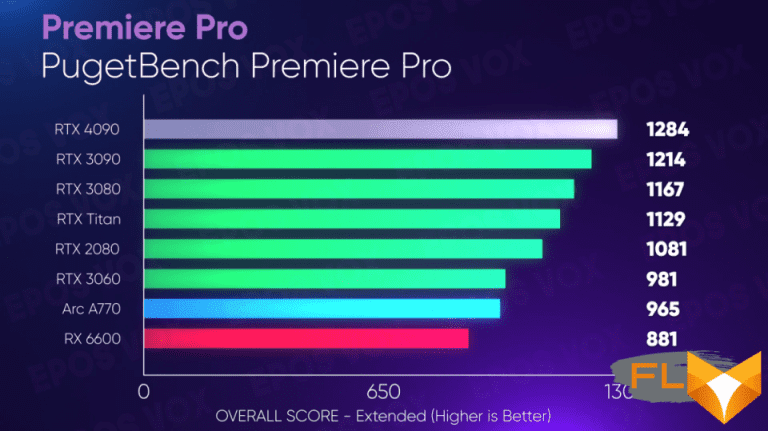

Production vidéo

Mon travail quotidien est, bien sûr, de créer du contenu YouTube, donc l’une des premières choses que j’ai dû tester serait les avantages que je pourrais voir pour la création de contenu vidéo. En utilisant PugetBench des constructeurs de stations de travail de Puget Systems, Adobe Premiere Pro constate une amélioration très minime des performances avec le RTX 4090 (comme on pouvait s’y attendre à ce stade).

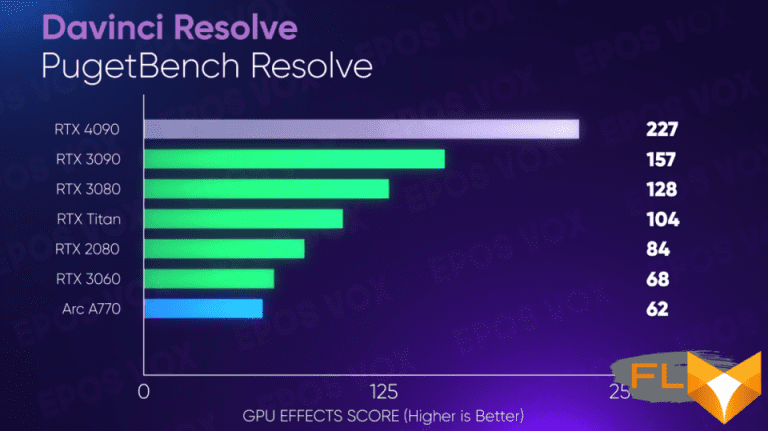

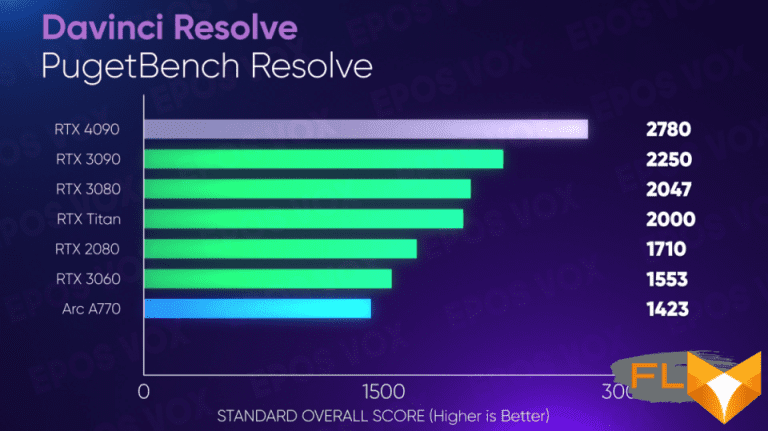

BlackMagic DaVinci Resolve, cependant, a vu des améliorations de performances significatives à tous les niveaux par rapport au RTX 3090 et au RTX Titan. Cela a du sens, car Resolve est beaucoup plus optimisé pour les flux de travail GPU que Premiere Pro. Les rendus étaient beaucoup plus rapides grâce à la fois au calcul 3D plus élevé sur les effets, mais aussi au matériel d’encodage plus rapide intégré, et la lecture générale et le flux de travail étaient beaucoup plus « rapides » et réactifs.

J’édite avec la GeForce RTX 4090 depuis quelques semaines maintenant, et l’expérience a été formidable, même si j’ai dû revenir à la version publique de Resolve, je n’ai donc pas pu exporter à l’aide de l’encodeur AV1 pour la plupart. de mes vidéos.

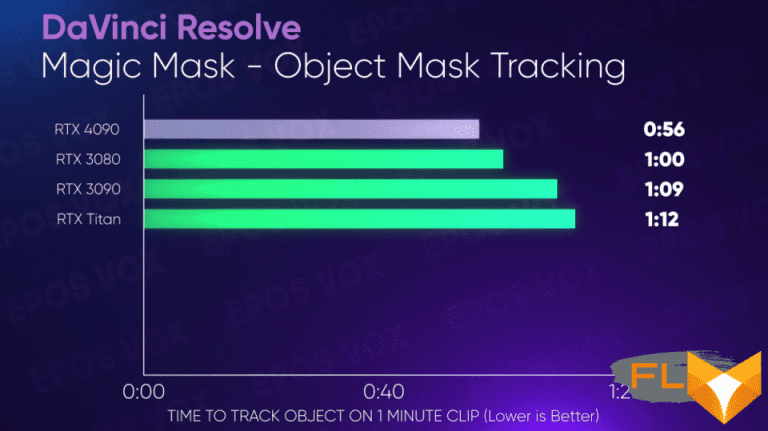

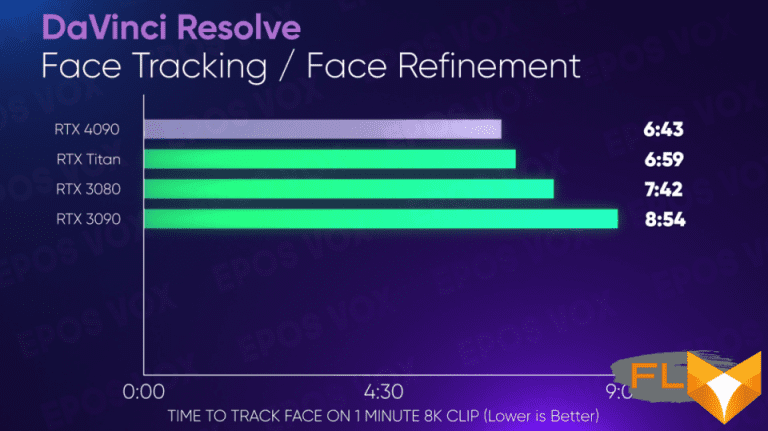

Je voulais également tester pour voir si les améliorations matérielles de l’IA profiteraient à l’outil Magic Mask de Resolve pour la rotoscopie, ou à leur suivi de visage pour le plugin Face Refinement. Certes, j’espérais voir plus d’améliorations du RTX 4090 ici, mais il y a une amélioration, ce qui me fait gagner du temps et c’est une victoire. Ces tâches sont fastidieuses et lentes, donc toutes les minutes que je peux gagner me facilitent la vie. Peut-être qu’avec le temps, une optimisation supplémentaire pourra être effectuée spécifiquement pour les nouveaux changements d’architecture dans Lovelace (nom de code de l’architecture GPU sous-jacente de la série RTX 40).

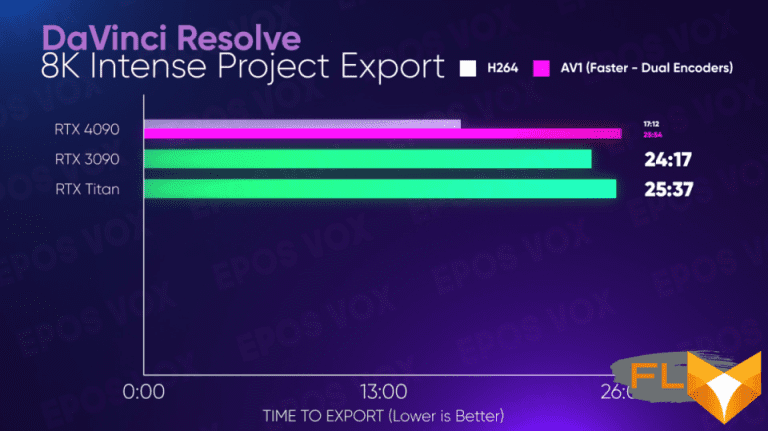

Les performances de mes benchmarks Resolve d’origine m’ont suffisamment impressionné pour que j’ai décidé de créer un test de deuxième niveau à l’aide de ma station de travail Threadripper Pro. le rendu et l’exportation d’une vidéo 8K avec des séquences source 8K RAW, de nombreux effets et Super Scale (l’upscaler « intelligent » interne de Resolve) sur des séquences 4K, etc. Ce projet n’est pas une blague, les cartes de jeu normales de haut niveau se sont juste des quantités de VRAM inférieures ne pouvaient pas gérer le projet – cela exclut les RTX 3060, 2080 et 3080 de la course. Mais en mettant à l’épreuve les monstres VRAM de 24 Go, le RTX 4090 a exporté les projets 8 minutes plus vite que le test. Huit minutes. Ce type de mise à l’échelle du temps change la donne pour les flux de travail d’une seule personne comme le mien.

Si vous êtes un éditeur vidéo haute résolution ou lourd en effets, le RTX 4090 va déjà vous faire économiser des heures d’attente et de travail plus lent, dès le départ et nous n’avons même pas encore parlé des vitesses d’encodage.

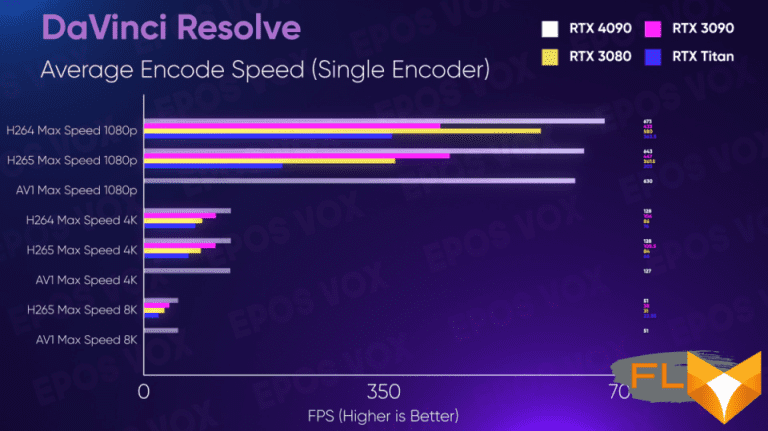

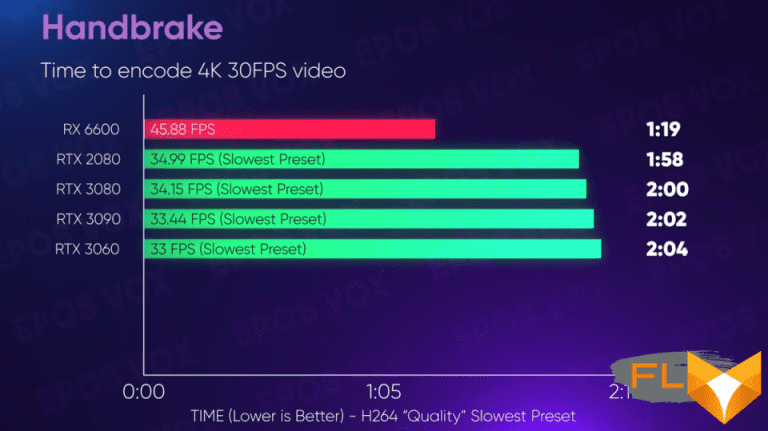

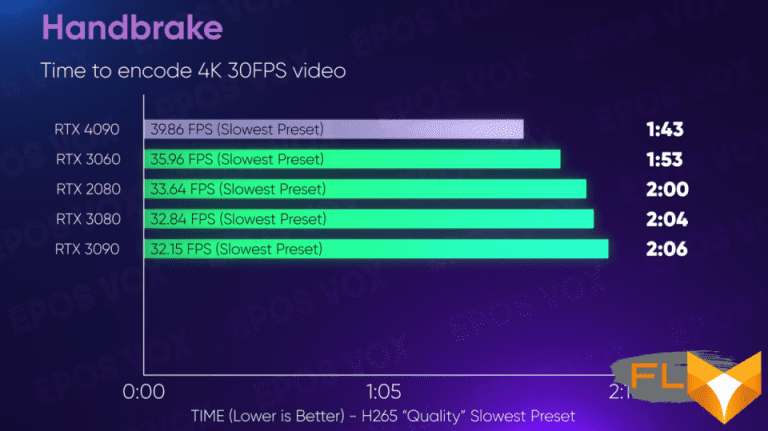

Encodage vidéo

Pour transcoder simplement la vidéo en H.264 et H.265, la GeForce RTX 4090 exécute également des tours autour des GPU Nvidia précédents. H.265 est le seul domaine où AMD surpasse Nvidia en termes de vitesse d’encodage (mais pas nécessairement en qualité), car depuis les GPU Radeon 5000, l’encodeur HEVC d’AMD a été extrêmement rapide.

La nouvelle architecture Ada Lovelace est également livrée avec de nouvelles puces à double encodeur qui fonctionnent déjà individuellement un peu plus rapidement pour l’encodage H.264 et H.265 qu’Ampere et Turing, mais elles encodent également AV1, le nouveau codec vidéo open source du Alliance pour les médias ouverts.

AV1 est l’avenir de la vidéo diffusée sur le Web, la plupart des grandes entreprises impliquées dans la diffusion multimédia étant également membres du consortium. L’objectif est de créer un codec vidéo hautement efficace (comme dans une meilleure qualité par bit) qui peut répondre aux besoins du monde moderne de la haute résolution, de la fréquence d’images élevée et du streaming HDR, tout en évitant les coûts élevés de licence et de brevet associés à H Codecs .265 (HEVC) et H.266. Intel a été le premier à commercialiser des encodeurs matériels AV1 avec leurs GPU Arc comme je l’ai couvert pour PCWorld ici – maintenant Nvidia l’apporte à leurs GPU.

Je ne peux pas encore obtenir de comparaisons de qualité complètement précises entre les encodeurs AV1 d’Intel et de Nvidia en raison d’un support logiciel limité. D’après les tests de base que j’ai pu faire, les encodages AV1 de Nvidia sont à égalité avec ceux d’Intel, mais j’ai depuis découvert que les implémentations d’encodeurs, même dans les logiciels dans lesquels je peux les utiliser, pourraient nécessiter des ajustements pour mieux représenter les deux côtés.

En termes de performances, AV1 fonctionne à peu près aussi vite que H.265/HEVC sur le RTX 4090. Ce qui est bien. Mais les nouvelles puces à double encodeur permettent d’utiliser à la fois H.265 et AV1 pour encoder une vidéo 8K60, ou simplement une vidéo 4K60 plus rapide. Pour ce faire, ils divisent les images vidéo en moitiés horizontales, codent les moitiés sur des puces séparées, puis les assemblent avant de finaliser le flux. Cela ressemble à la façon dont l’Hyper Encode d’Intel était censé fonctionner – Hyper Encoder séparait plutôt les GOP (groupe d’images ou d’images) entre l’iGPU et le dGPU avec Arc – mais dans tous mes tests, je n’ai trouvé que l’Hyper Encode pour ralentir le processus, plutôt que de l’accélérer. (De plus, cela ne fonctionnait pas avec AV1.)

Diffusion

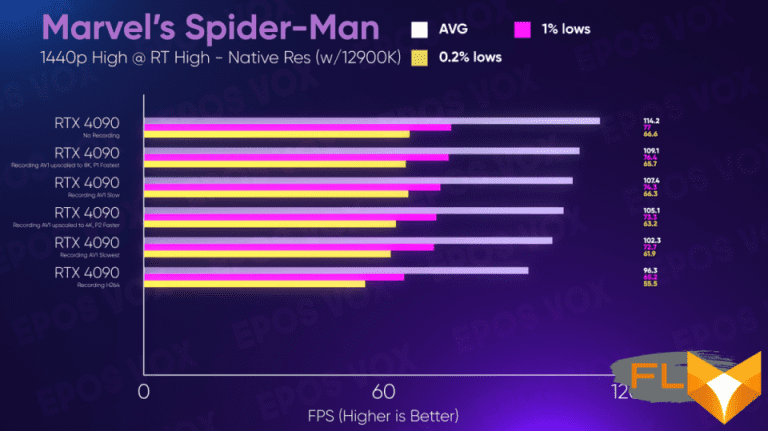

Grâce aux améliorations susmentionnées de la vitesse de l’encodeur, la diffusion en continu et l’enregistrement de votre écran, de votre caméra ou de votre jeu sont une bien meilleure expérience. Cela vient avec une mise à jour du SDK de l’encodeur NVENC dans OBS Studio, présentant désormais aux utilisateurs 7 préréglages (semblables aux « préréglages d’utilisation du processeur » de X264), passant de P1 étant la qualité la plus rapide/la plus basse à P7 étant la qualité la plus lente/meilleure. Lors de mes tests dans cette vidéo, P6 et P7 avaient fondamentalement le même résultat sur les GPU RTX 2000, 3000 et 4000, et rivalisaient de qualité avec X264 VerySlow.

Pendant le streaming du jeu, j’ai vu principalement les mêmes performances d’enregistrement que les autres GPU dans Spider-Man Remastered (bien que d’autres jeux verront plus d’avantages) avec H.264, mais ensuite l’encodage avec AV1… a eu un impact négligeable sur les performances du jeu. C’était pratiquement transparent. Vous ne sauriez même pas que vous enregistrez, même sur le préréglage de la plus haute qualité. J’avais même assez de marge pour régler OBS sur une toile 8K et mettre à l’échelle ma capture de jeu 1440p à 8k dans OBS et enregistrer à l’aide des puces à double encodeur, et je ne vois toujours pas d’impact significatif.

Malheureusement, alors que la fonction Shadowplay de Nvidia bénéficie de la prise en charge de 8K60 sur Lovelace via les encodeurs doubles, seul HEVC est pris en charge pour le moment. Espérons que AV1 puisse être implémenté et pris en charge pour toutes les résolutions, car HEVC ne fonctionne que pour 8K ou HDR tel quel, bientôt.

J’ai également constaté que la GeForce RTX 4090 est désormais suffisamment rapide pour effectuer un enregistrement HEVC 4: 4: 4 totalement sans perte à 4K 60FPS, ce que les générations précédentes ne peuvent tout simplement pas faire. Le sous-échantillonnage de chrominance 4: 4: 4 est important pour maintenir la clarté du texte et pour garder l’image intacte lors d’un zoom avant sur de petits éléments comme je le fais pour les vidéos, et à 4K, c’est en quelque sorte une «baleine blanche» à moi, car le débit sur RTX 2000/3000 n’a pas suffi ou l’implémentation OBS de 4:4:4 n’est pas suffisamment optimisée. Malheureusement, 4: 4: 4 n’est pas du tout possible en AV1 sur ces cartes.

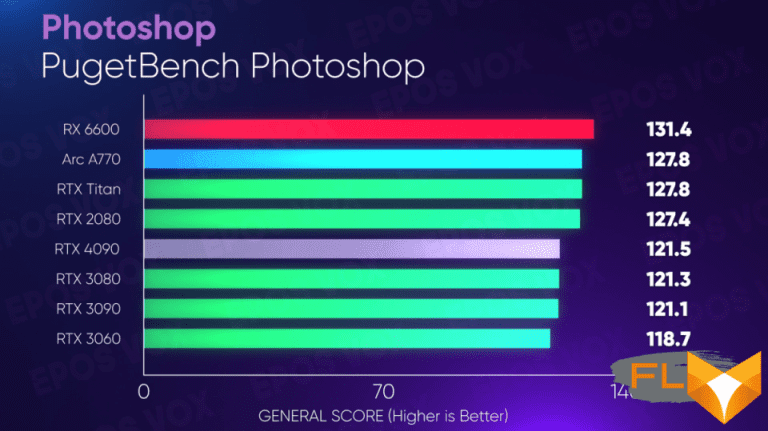

Retouche photo

La retouche photo ne voit pratiquement aucune amélioration sur la GeForce RTX 4090. Il y a une légère augmentation du score sur les tests Adobe Photoshop PugetBench par rapport aux générations précédentes, mais rien ne vaut l’achat d’une nouvelle carte.

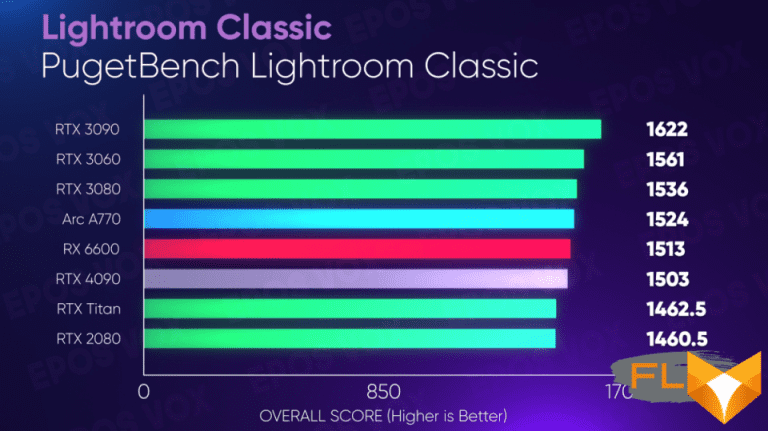

Il en va de même pour Lightroom Classic. Honte.

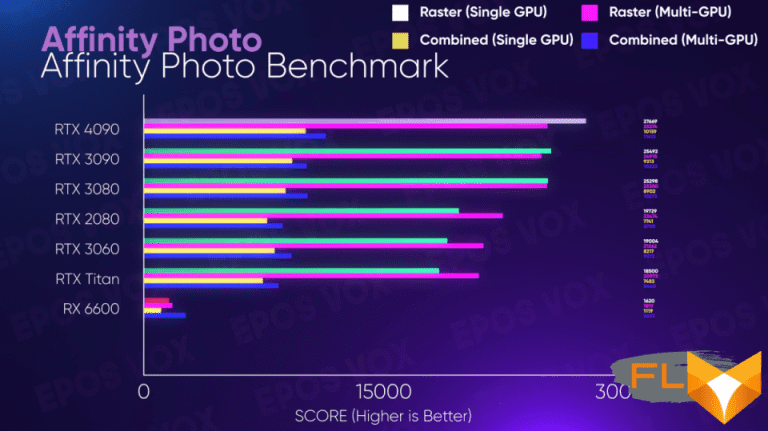

Mais si vous êtes un utilisateur d’Affinity Photo, le RTX 4090 surpasse de loin les autres GPU, je ne sais pas s’il faut interpréter qu’Affinity est plus ou moins optimisé dans ce cas.

Intelligence Artificielle

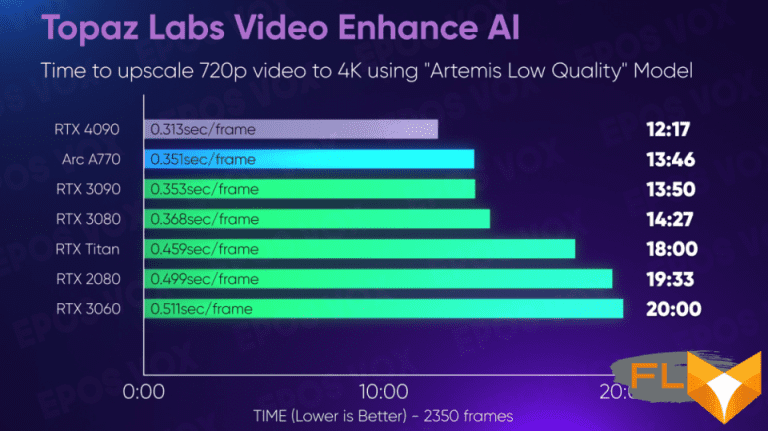

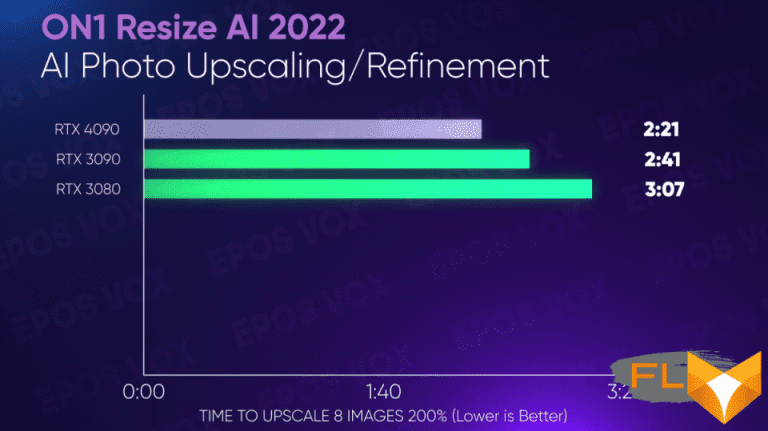

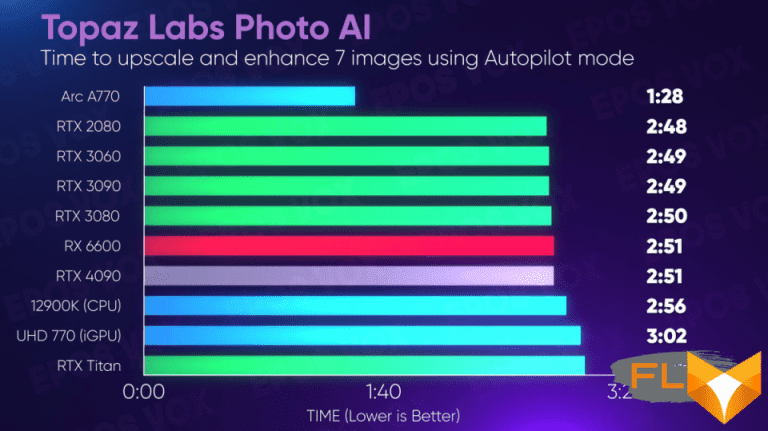

L’IA fait fureur ces jours-ci, et les upscalers d’IA sont très demandés en ce moment. Théoriquement, le matériel AI amélioré de la GeForce RTX 4090 profiterait à ces flux de travail – et nous voyons surtout cela sonner vrai. Le RTX 4090 est en tête des classements pour la mise à l’échelle la plus rapide dans Topaz Labs Video Enhance AI et Gigapixel, ainsi que ON1 Resize AI 2022.

Mais la nouvelle application PhotoAI de Topaz voit des performances étrangement faibles dans toutes les cartes Nvidia. On m’a dit que c’était peut-être un bogue, mais un correctif n’a pas encore été distribué.

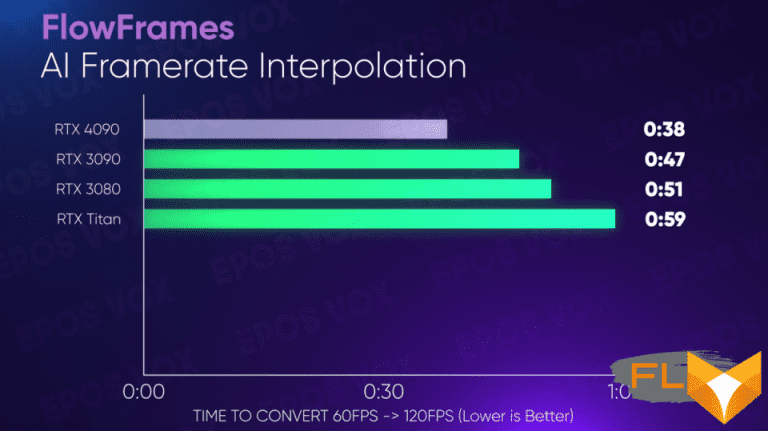

En utilisant FlowFrames pour IA interpoler des séquences de 60FPS à 120FPS pour une utilisation au ralenti, le RTX 4090 voit une accélération de 20% par rapport au RTX 4090. C’est bien comme ça, mais des utilisateurs m’ont dit dans le FlowFrames Discord serveur que cela pourrait théoriquement évoluer davantage à mesure que des optimisations pour Lovelace sont développées.

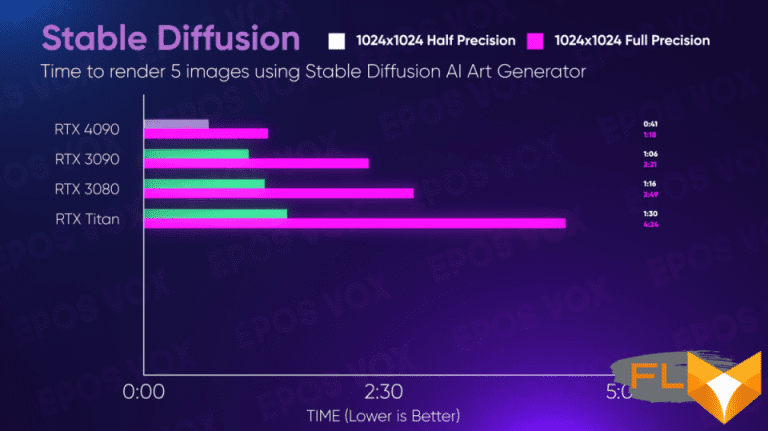

Qu’en est-il de la génération d’IA Art ? J’ai testé l’interface graphique de diffusion stable de N00mkrad et j’ai constaté que la GeForce RTX 4090 avait fait exploser tous les GPU précédents en demi-précision et en pleine précision – et une fois de plus, on m’a dit que les résultats « devraient être » plus élevés, même. Des moments passionnants.

Rendu 3D

D’accord, les affirmations audacieuses « 2X plus rapide » sont ici. Je souhaitais tester des workflows 3D sur mon rig Threadripper Pro, car je me suis de plus en plus familiarisé avec ces nouveaux outils en 2022.

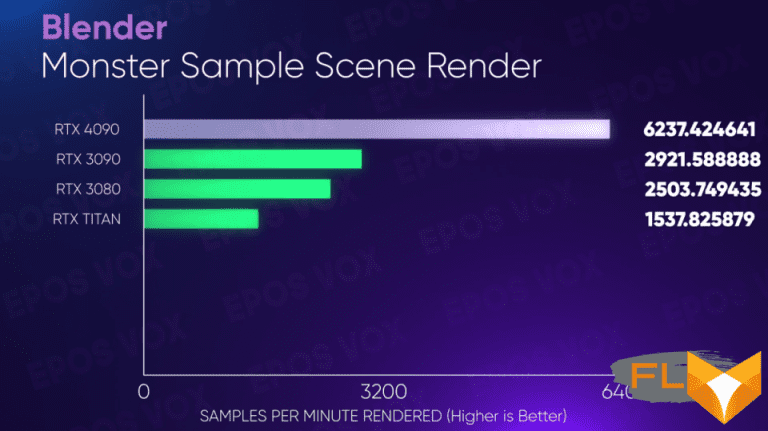

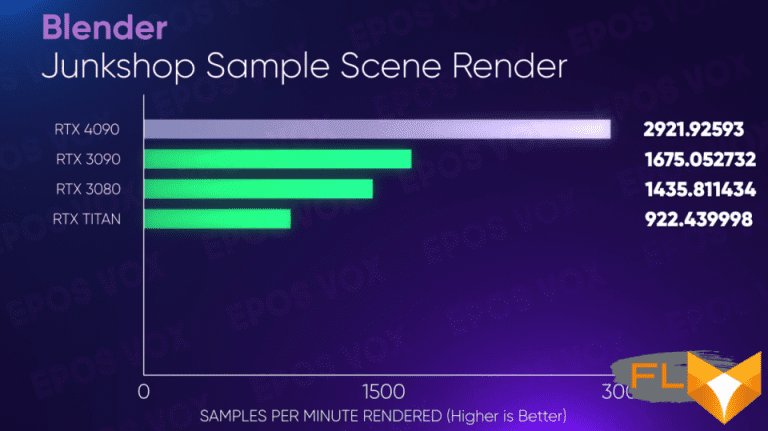

En testant Blender, les scènes de référence Monster et Classroom ont le rendu RTX 4090 deux fois plus rapide que le RTX 3090, avec le rendu de la scène Junkshop juste 2 fois plus rapide.

Cela se traduit non seulement par des rendus finaux plus rapides, ce qui à grande échelle est absolument énorme, mais également par un processus de création beaucoup plus fluide, car tout le travail de prévisualisation / fenêtre d’affichage sera également plus fluide et réactif, et vous pourrez plus facilement prévisualiser les résultats finaux sans attendre pour toujours.

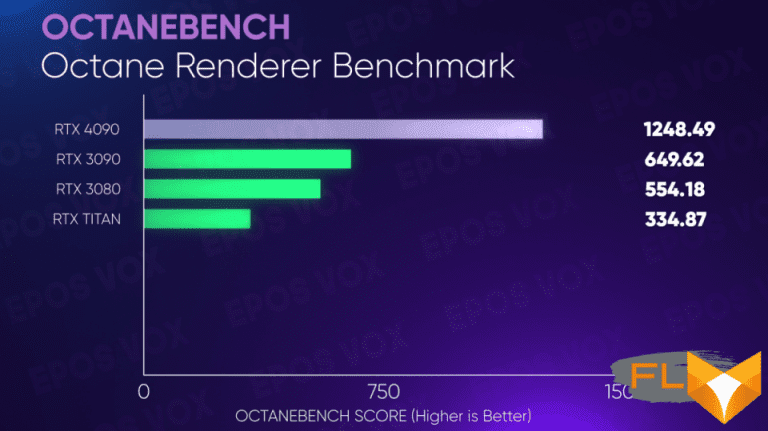

L’analyse comparative d’Octane, un moteur de rendu utilisé par les artistes 3D et les créateurs d’effets visuels dans Cinema4D, Blender et Unity, permet à nouveau au RTX 4090 de fonctionner deux fois plus vite que le RTX 3090.

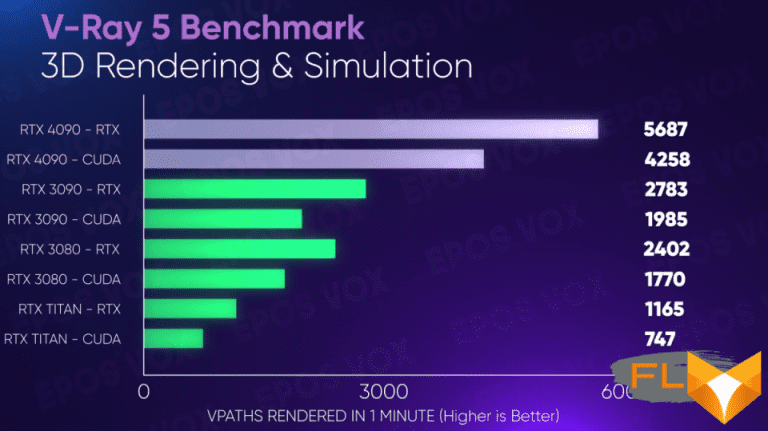

… et encore une fois, il en va de même pour V-Ray dans les flux de travail CUDA et RTX.

Bottom line: La GeForce RTX 4090 offre une valeur exceptionnelle aux créateurs de contenu

C’est là que se trouve la valeur. Le Titan RTX coûtait 2 500 $, et il était déjà phénoménal d’obtenir cette performance pour 1 500 $ avec le RTX 3090. Maintenant, pour 100 $ de plus, le GeForce RTX 4090 exécute des tours autour des GPU précédents d’une manière qui a vraiment un impact révolutionnaire sur les flux de travail pour les créateurs de toutes sortes.

Cela pourrait expliquer pourquoi la gamme de cartes anciennement connue sous le nom de Quadro a également reçu beaucoup moins d’attention au cours des dernières années. Pourquoi acheter une carte graphique à plus de 5 000 $ alors que vous pouvez obtenir les mêmes performances (ou plus, les Quadros n’ont jamais été super rapides, ils avaient juste beaucoup de VRAM) pour 1 600 $ ?

De toute évidence, le prix du RTX 4080 à 1 200 $ et du 899 $ 4080 12 Go récemment non lancé peut toujours être préoccupant jusqu’à ce que nous voyions des chiffres de tests indépendants, mais le GeForce RTX 4090 pourrait bien être la première fois que le marketing se vante de performances « 2x plus rapides » sur un produit et j’ai l’impression d’avoir effectivement reçu cette promesse. Surtout pour des résultats dans mes intérêts de travail de niche au lieu d’outils ou de jeux grand public ? C’est génial.

Les joueurs purs ne devraient probablement pas dépenser 1 600 $ sur une carte graphique, à moins que l’alimentation d’un moniteur 4K à taux de rafraîchissement élevé sans compromis ne soit un objectif. Mais si vous souhaitez accomplir rapidement un travail de création de contenu réel et minutieux, la GeForce RTX 4090 est imbattable – et elle vous fera sourire d’une oreille à l’autre lors de toutes les sessions Call of Duty de fin de soirée. hop aussi.